- サポートベクターマシン(SVM)の中身を理解したい人

- オススメの本を知りたい人

- 機械学習に携わる人

こんにちは.けんゆー(@kenyu0501_)です.

研究に使うためのツールとしてサポートベクターマシン(SVM)を勉強しました.

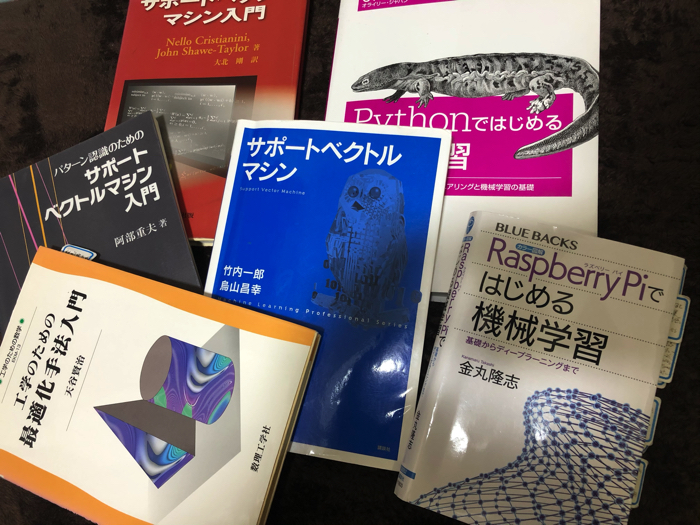

その中でも,おいらがSVMを理解するために熟読した本を6つ紹介します.

おいらがまとめた資料を先に紹介

これから紹介する本などを熟読してスライド資料を作りました.

SVMを簡単に知りたいという人は見てみてください.

【オススメ本1】サポートベクトルマシン

サポートベクトルマシンは理解しようと思えばかなり奥が深いので,このタイトルで本が一冊かけます.

その中でもこの青い表紙のフクロウが書かれている本「サポートベクトルマシン」は分かりやすさでいうと最も優れた良書だと断言します.

本を構成するための,「数式」と「説明文章」,「図」をの3つを使う割合が完璧で,初学者〜中級者あたりでも優しく理解できると思います.2015年に書かれた本で新しいです.

【オススメ本2】パターン認識のためのサポートベクトルマシン入門

2011年に出版されたこちらの本も参考になりました.

基本的に,ある専門分野を理解しようと思った場合,専門書は3冊くらい読んだ方が理解度が上がります.

大事なキーポイントをいろんな著者の言葉で読むことによって,解釈のスピードが上がります.

本書の立ち位置は,上で挙げた「オススメ本1」の補足です.

野球でいうところの中継ぎ的存在ですね.

ヤクルトに復帰した中継ぎ最強投手「五十嵐亮太」みたいな本です.

(野球はあんまり詳しくないけど,,,)

【オススメ本3】サポートベクターマシン入門

最後にオススメするSVMの本はこちら.

「入門」とついていますが,正直初心者には読むのは苦しかった一冊です.

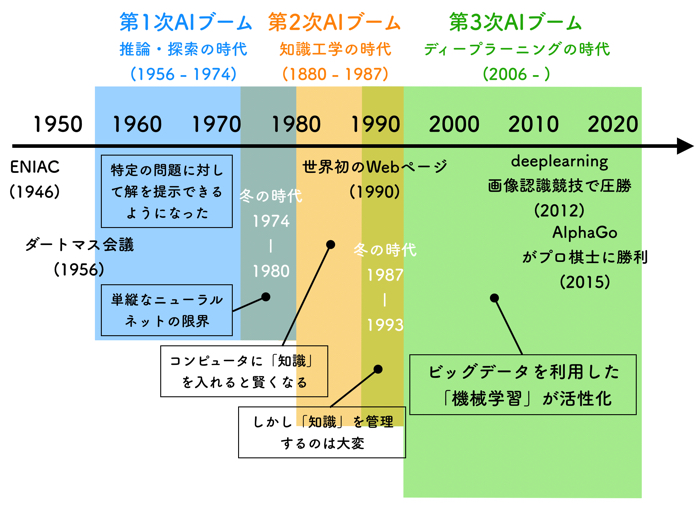

2005年に書かれていて,まだディープラーニングが時代を圧巻していない時代に書かれた本です.

当時,分類や回帰に関しては,機械学習が最も優れた方法だと信じられていた側面があり,そういった時代背景を加味して読むと面白いです.SVMは当時はすごい技術だったのだな,と認識させられます.

ちょっと古い本になりますが,日本語の貴賓(きひん)さには感動を覚えます.

ついついこんなツイートをしてしまいました.

最近発売された専門書ってものすごく工夫されてて、読みやすく理解度は速いけど、文書似たり寄ったり。

2000年くらいに書かれた本は、文字びっしりだけど、こういう表現もあるんだと感動させられます。

日本語が深いっす。

— けんゆー@博士課程 (@kenyu0501_) May 9, 2019

s最近発売された専門書ってものすごく工夫されてて,読みやすく理解度は速いけど,文章似たり寄ったり.

2000年くらいに書かれた本は,文字びっしりだけど,こういう表現もあるんだと感動させられます.

日本語が深いです.

【オススメ本4】工学のための最適化手法入門

サポートベクターマシンの双対問題を解くときにラグランジュの未定乗数法というものが出てきますが,この本が一番理解しやすかったです.

この本は,SVMだけではなく,その他多くの最適化問題の理解に役に立つ本だと思います.

分かりやすくて,例題多くてオススメ!

【オススメ本5】RaspberryPiではじめる機械学習

カラー図解 Raspberry Piではじめる機械学習 基礎からディープラーニングまで

これは,pythonでプログラム実装をするときに大いに役に立つ本です.

RaspberryPiという小型PC用の本として書かれていますが,全く関係ないです.

Pythonが走るのであれば,windowsPCでもMacPCでも良いです.

(あえて,OSではなくPCという言い方をしてます.)

サポートベクターマシンとディープラーニングの実装の本ではこの本はかなり分かりやすい部類に入る良書だと感じます.

サポートベクターマシンの詳しい理論的な理解を得るため,【オススメ本1】と同時に見ることをオススメしておきます.

【オススメ本6】 Pythonではじめる機械学習

こちらの本は完全にpythonのプログラムの本です.

理論的な説明はありませんが,pythonでのSVMの組み方,パラメータチューニングの方法など役に立ちます.

SVMに関するページ数はかなり少ないものの,プログラムを組むにあたって必要な知識が身につきます.

深層学習が騒がれている昨今ですが,まだまだ機械学習も面白いので是非試してみてくださいねー!

こちらの記事もオススメです.

この記事はこんな人にオススメです サポートベクターマシンSVMについて詳しく知りたい方 機械学習で分類や回帰な…

けんゆー様

御忙しいところ失礼いたします

機械学習初心者です。いつもサイト見てます。

課題で教師なし学習なしにおけるランダムフォレストを勉強してくるように言われたのですが、参考にしているサイトの文章で日本語にしても理解できないところがあります。ご教示願いたいです。

A joint distribution of the explanatory variables is constructed and draws are taken from this distribution to create synthetic data. In most cases the the same number of draws as in the real data set will be taken.

The real and synthetic data are combined. A label is then created, say 1 for the real data and 0 for the synthetic data.

以下URLです。

gradientdescending.com/unsupervised-random-forest-example/